学习链接:linux内存管理(详解) - 知乎 (zhihu.com)

1.虚拟地址:

内存是计算机里面很宝贵的资源

为了充分利用和管理系统内存资源linux采用了虚拟内存管理技术,利用虚拟内存技术让每一个进程都有4GB互不干扰的虚拟地址空间

进程初始化分配和操作都是基于这个虚拟地址。只用当进程需要实际访问内存资源的时候才会建立许你辞职和物理地址的映射,调入物理内存页

虚拟地址的好处:

- 避免了用户直接访问物理地址内存,进行一些破坏操作,保护操作系统

- 每一个进程都被分配了4GB的虚拟内存,用户程序可使用比实际物理内存更大的地址空间

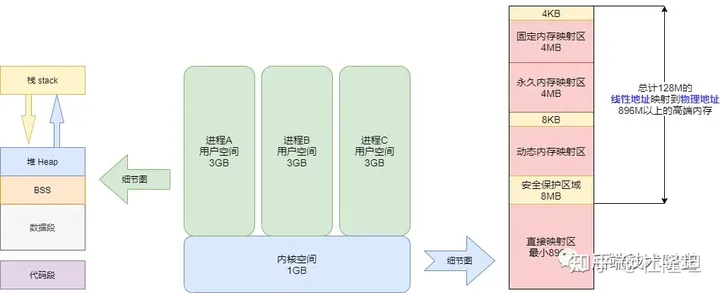

4GB 的进程虚拟地址空间被分成两部分:「用户空间」和「内核空间」

2.物理地址:

上面我们知道了不管是用户空间还是内核空间,使用的地址都是虚拟地址,当需要实际访问内存的时候,会由内核的请求分页机制产生缺页异常调入物理内存页。

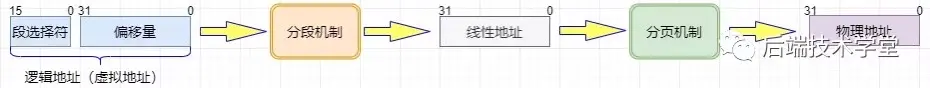

把虚拟内存地址转化成内存的物理地址,这种中间涉及利用MMU内存管理单元(Memory Management Unit )对虚拟地址分段和分页(段页式)地址转换

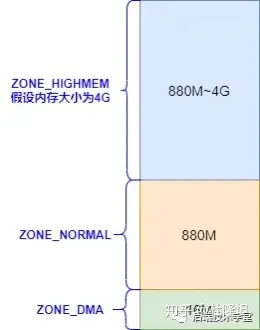

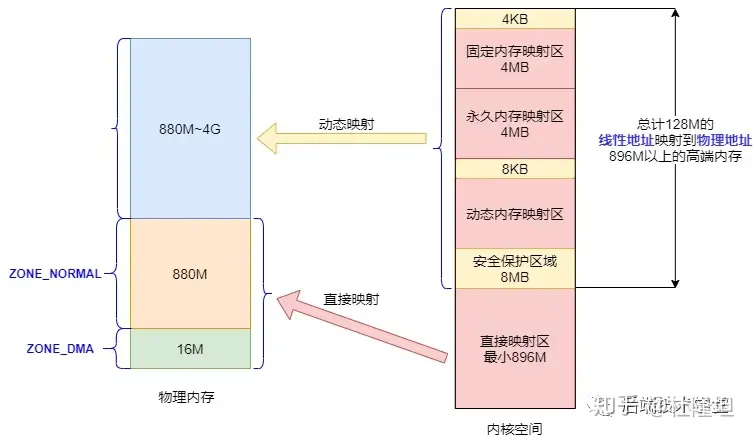

linux内核会将物理地址分为三个管理区:

ZONE_DMA

DMA内存区域。包含了0MB到896MB之间的内存页框,常规页框,直接映射到内核的地址空间。

ZONE_NORMAL

普通的内存区域。包含16MB到896MB的内存框,可以由老式基于ISA的设备通过DMA使用,直接映射到内核的地址空间。

ZONE_HIGHMEM

高端内存区域。包含896MB以上的内存页框,不进行直接映射,可以通过永久映射和临时映射进行这部分内存页框的访问。

3.用户空间:

用户进程能访问的是用户空间,每一个进程都有自己独立的用户空间,虚拟地址范围从0x00000000到0xBFFFFFFF,总容量3G

用户进程通常只能访问用户空间的虚拟地址,只有在执行内核操作或系统调用的时候才能访问内核空间。

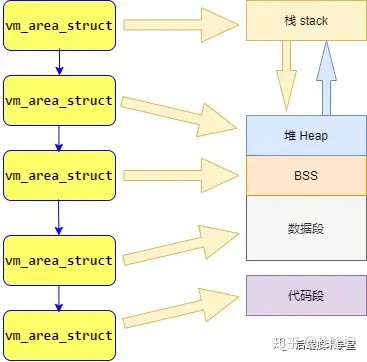

4.进程和内存

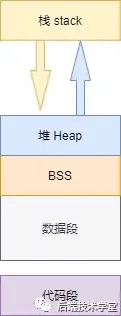

进程(执行的程序)占用的用户空间按照访问属性一致的地址空间放在一起的原则,划分成5个不同的内存区域。访问属性指的是“可读可写可执行等”。

代码段:

代码段是用来存放可执行文件的操作指令,可执行程序在内存中的镜像。代码段需要防止在运行的时候被非法修改,所以只许可读不可写

数据段:

数据段用来存放可执行文件中已经初始化全局变量,换句话来说是存放程序静态分配的变量和全局变量。

BSS段:

BSS段包含了程序中未初始化的全局变量,在内存中 bss 段全部置零。

堆(heap):

堆是用于存放进程运行里面别动态分配的内存段,它的大小并不固定,可动态扩张或缩减。当进程调用malloc等函数分配内存的时候,新分配的内存就被动态加载到了堆里面(堆被扩张);当利用free等函数释放内存的时候,被释放的内存从堆里面被剔除(堆被缩减)

栈(stack):

栈是用户存放程序临时创建的局部变量,也就是函数中定义的变量(但是不包括static声明的变量,static意味着数据段中存放的变量)。除此之外,函数再被调用的时候,其参数也会被压入发起调用的进程栈里面,并且等到调用结束过后,函数的返回值也会被存放返回栈里面。由于栈的先进先出的特点,所以栈特别方便用来保存/恢复调用现场。从这个意义上来看,栈可以被看作是一个寄存、交换临时数据的内存区。

上述几种内存区域中数据段、BSS 段、堆通常是被连续存储在内存中,在位置上是连续的,而代码段和栈往往会被独立存放。堆和栈两个区域在 i386 体系结构中栈向下扩展、堆向上扩展,相对而生。

也可以在linux下面使用size查看斌阿姨过后各个区域的大小:[lemon ~]# size /usr/local/sbin/sshd text data bss dec hex filename1924532 12412 426896 2363840 2411c0 /usr/local/sbin/sshd

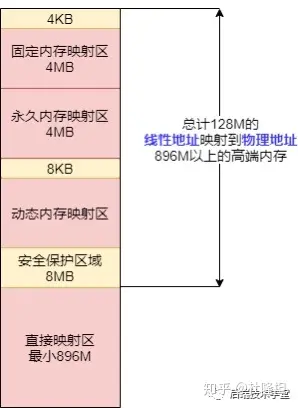

5.内核空间:

在x86 32系统里面,Linux内核地址空间是指从0xC0000000开始到0xFFFFFFFF为止的高端内存地址空间,一共1G,包含了内核镜像、物理页面表、驱动程序等运行在内核空间。

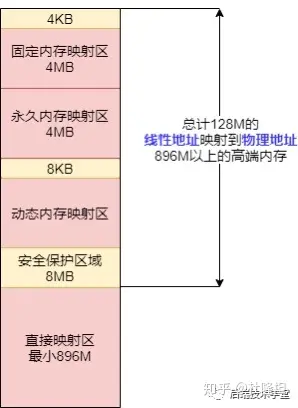

直接映射区:

直接映射区 Direct Memory Region:从内核空间起始地址开始,最大896M的内核空间地址区间,为直接内存映射区。

直接映射区的896MB的「线性地址」直接与「物理地址」的前896MB进行映射,也就是说线性地址和分配的物理地址都是连续的。内核地址空间的线性地址0xC0000001所对应的物理地址为0x00000001,它们之间相差一个偏移量PAGE_OFFSET = 0xC0000000

该区域的线性地址和物理地址存在线性转换关系「线性地址 = PAGE_OFFSET + 物理地址」也可以用 virt_to_phys()函数将内核虚拟空间中的线性地址转化为物理地址。

高端内存线性地址空间;

内核空间线性地址从 896M 到 1G 的区间,容量 128MB 的地址区间是高端内存线性地址空间,为什么叫高端内存线性地址空间?

前面已经说过,内核空间的总大小 1GB,从内核空间起始地址开始的 896MB 的线性地址可以直接映射到物理地址大小为 896MB 的地址区间。前面已经说过,

退一万步,即使内核空间的1GB线性地址都映射到物理地址,那也最多只能寻址 1GB 大小的物理内存地址范围。

我们的内存条已经早就大于1GB了吧!

所以,内核空间拿出了最后的 128M 地址区间,划分成下面三个高端内存映射区,以达到对整个物理地址范围的寻址。而在 64 位的系统上就不存在这样的问题了,因为可用的线性地址空间远大于可安装的内存。

动态内存映射区:

vmalloc Region 该区域由内核函数vmalloc来分配,特点是:线性空间连续,但是对应的物理地址空间不一定连续。vmalloc 分配的线性地址所对应的物理页可能处于低端内存,也可能处于高端内存。

永久内存映射区:

Persistent Kernel Mapping Region 该区域可访问高端内存。访问方法是使用 alloc_page (_GFP_HIGHMEM) 分配高端内存页或者使用kmap函数将分配到的高端内存映射到该区域。

固定映射区:

Fixing kernel Mapping Region 该区域和 4G 的顶端只有 4k 的隔离带,其每个地址项都服务于特定的用途,如 ACPI_BASE 等。

回顾一下:

6.内存数据结构:

要让内核管理系统中的虚拟内存,必然要从中抽出内存管理数据结构,内存管理操作如分配释放等都基于这些数据结构操作,这里列举两个管理虚拟内存区域的数据结构。

用户空间内存数据结构:

在前面进程与内存里面提到过Linux进程可以划分为5个不同的内存区域,分别是:代码段、数据段、BSS、堆、栈,内核管理这些区域的方法是将这些内存区域抽象成:vm_area_struct的内存管理对象。struct vm_area_struct {

struct mm_struct *vm_mm; // 指向所属进程的内存描述符(memory descriptor)

unsigned long vm_start; // 区域起始地址

unsigned long vm_end; // 区域结束地址的下一个地址

pgoff_t vm_pgoff; // 在文件中的偏移量(如果映射到文件的话)

unsigned long vm_flags; // 区域标志,如读写权限、共享等

struct rb_node vm_rb; // 红黑树节点,用于管理虚拟内存区域的插入和查找

struct vm_area_struct *vm_next; // 指向下一个虚拟内存区域的指针

};

- 管理虚拟内存区域:每个

vm_area_struct结构体实例代表了进程虚拟地址空间中的一个连续的内存区域,用于管理进程的内存映射和页表信息。 - 地址空间的描述:通过

vm_start和vm_end定义了虚拟内存区域的起始和结束地址,以及vm_flags定义了这个区域的属性,如读写权限、映射方式等。 - 文件映射管理:如果虚拟内存区域映射到文件(如共享库或映射的文件),

vm_pgoff表示了在文件中的偏移量。 - 红黑树支持:

vm_rb字段用于在内核中维护 的红黑树中进行快速查找和插入,以提高对虚拟内存区域的管理效率。 - 链表结构:

vm_next指向链表中的下一个vm_area_struct结构,用于链接同一个进程的所有虚拟内存区域。

vm_area_struct是描述进程 地址空间的基本管理单元,一个进程往往需要多个vm_area_struct来描述它的用户空间虚拟地址,需要使用「链表」和「红黑树」来组织各个vm_area_struct。

链表用于需要遍历全部节点的时候用,而红黑树适用于在地址空间中定位特定内存区域。内核为了内存区域上的各种不同操作都能获得高性能,所以同时使用了这两种数据结构。

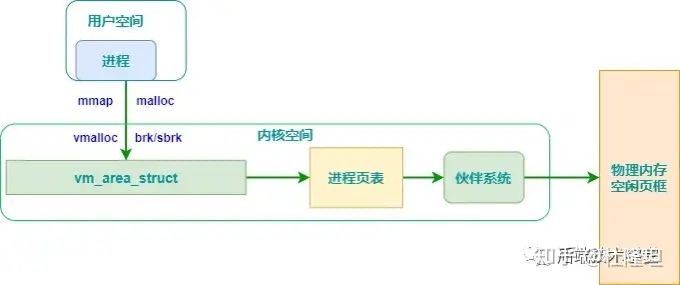

用户空间进程的地址管理模型:

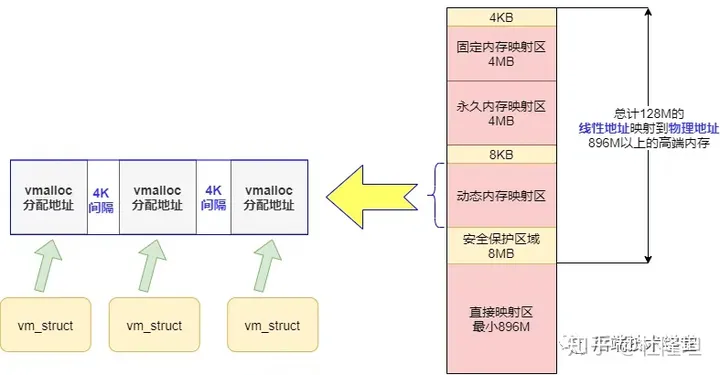

内核空间动态分配内存数据结构:

在内核空间章节我们提到过「动态内存映射区」,该区域由内核含糊vmalloc来分配,

特点是:线性空间连续,但是对应的物理地址空间不一定连续。vmalloc 分配的线性地址所对应的物理页可能处于低端内存,也可能处于高端内存。

vmalloc 分配的地址则限于vmalloc_start与vmalloc_end之间。每一块vmalloc分配的内核虚拟内存都对应一个vm_struct结构体,不同的内核空间虚拟地址之间有4k大小的防越界空闲区间隔区。

与用户空间的虚拟地址特性一样,这些虚拟地址与物理内存没有简单的映射关系,必须通过内核页表才可转换为物理地址或物理页,它们有可能尚未被映射,当发生缺页时才真正分配物理页面。

前面分析了Linux内存管理机制,下面学习一下物理内存管理和虚拟内存分配。

通过前面的学习可以得知,程序是没有这么好骗的,因为就算把虚拟地址玩出花,最后还是要给程序实实在在的物理内存,不然程序要罢工。

所以物理内存一定要好好利用起来(物理内存就是实实在在的内存条),那么内核是如何管理物理内存的?

7.物理内存管理:

在Linux系统中通过分段和分页机制,把物理内存划分 4K 大小的内存页 Page(也称作页框Page Frame),物理内存的分配和回收都是基于内存页进行,把物理内存分页管理的好处大大的。

假如系统请求一小块内存,可以先分配一页给它,避免了反复申请和释放小块内存带来的繁琐系统开销

假如系统需要大块内存,则可以用多页内存拼凑,而不必要求大块连续内存。你看不管内存大小都能收放自如,分页机制多么完美的解决方案!

但是如果直接这样吧内存分页使用,不加额外的管理还是存在一些问题,下面我们来看一下系统在多次分配释放内存页的时候会遇到哪些问题:

物理页管理面临的问题:

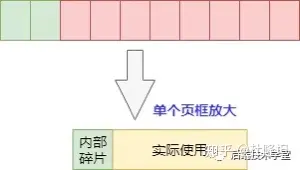

物理内存页分配会出现外部碎片和内部碎片的问题,所谓的「内部」和「外部」是针对「页框内外」而言,一个页框内的内存碎片是内部碎片,多个页框间的碎片是外部碎片。

外部碎片:

当需要分配大块内存的时候,要用好几页组合起来才够,而系统分配物理内存页的时候会尽量分配连续的内存页面,频繁的分配与回收物理页导致大量的小块内存夹杂在已分配页面中间,形成外部碎片,举个例子:

内部碎片:

物理内存是按页来分配的,这样当实际只需很小的内存的时候,也会分配至少是4k(4096字节)大小的页面,而内核里面有很多以字节为单位的分配场景,这样本来只想要几个字节而已但是却不得不分配一页的内存,除去用掉的字节剩下的就形成了内部碎片

页面管理算法:

方法总比困难多,因为上面的问题,所以程序员引用了页面管理算法来解决上面的碎片问题:

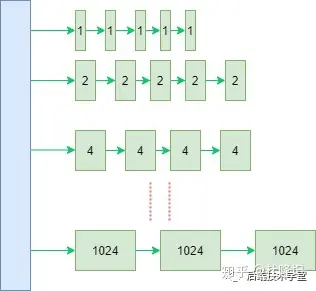

Buddy(伙伴)分配算法:

Linux内核引用了伙伴系统算法(Buddy system),这是什么意思呢?就是把相同大小的页框块用链表串起来

具体的,所有的空闲页框分组为11个块链表,每个块链表分别包含大小为1,2,4,8,16,32,64,128,256,512和1024个连续页框的页框块。最大可以申请1024个连续页框,对应4MB大小的连续内存。

因为任何正整数都可以由 2^n 的和组成,所以总能找到合适大小的内存块分配出去,减少了外部碎片产生 。

分配实例:

比如:我需要申请4个页框,但是长度为4个连续页框块链表没有空闲的页框块,伙伴系统会从连续8个页框块的链表获取一个,并将其拆分为两个连续4个页框块,取其中一个,另外一个放入连续4个页框块的空闲链表中。释放的时候会检查,释放的这几个页框前后的页框是否空闲,能否组成下一级长度的块。

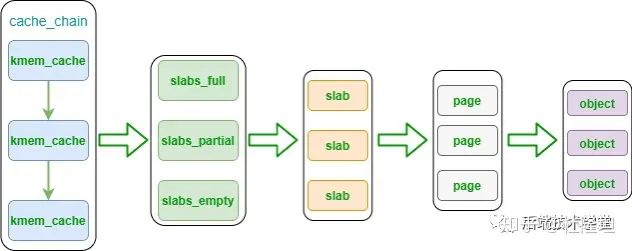

salb分配器:

只有一个伙伴系统还不够,那么什么是salb分配器呢?

一般来说,内核对象的生命周期是这样的:分配内存-初始化-释放内存,内核中有大量的小对象,比如文件描述结构对象、任务描述对象,如果按照伙伴系统按页分配和释放内存,对小对象频繁的执行「分配内存-初始化-释放内存」会非常消耗性能。

伙伴系统分配出去的对象是以页框为单位的,而对于内核的许多场景都是分配小片内存,远不到一页内存大小的空间。lsab分配器,「通过将内存按使用对象不同再划分成不同大小的空间」,应用于内核对象的缓存。

原理:

对于每个内核中的相同类型的对象,如:task_struct、file_struct 等需要重复使用的小型内核数据对象,都会有个 slab 缓存池,缓存住大量常用的「已经初始化」的对象,每当要申请这种类型的对象时,就从缓存池的slab 列表中分配一个出去;而当要释放时,将其重新保存在该列表中,而不是直接返回给伙伴系统,从而避免内部碎片,同时也大大提高了内存分配性能。

主要优点:

slab内存管理基于内核小对象,不用每次都分配一页内存,充分利用内存空间,避免内部碎片。slab对内核中频繁创建和释放的小对象做缓存,重复利用一些相同的对象,减少内存分配次数。

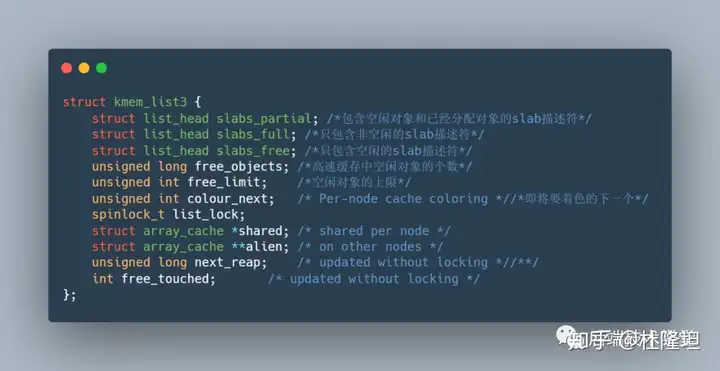

kmem_cache 是一个cache_chain 的链表组成节点,代表的是一个内核中的相同类型的「对象高速缓存」,每个kmem_cache 通常是一段连续的内存块,包含了三种类型的 slabs 链表:

slabs_full(完全分配的slab链表)slabs_partial(部分分配的slab链表)slabs_empty( 没有被分配对象的slab链表)

kmem_cache 中有个重要的结构体 kmem_list3 包含了以上三个数据结构的声明。

(不知道为什么没有在源码里面翻出来。)

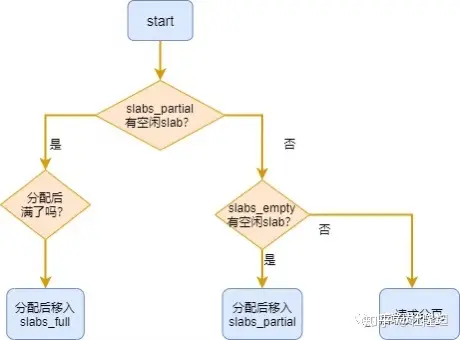

slab 是slab 分配器的最小单位,在实现上一个 slab 由一个或多个连续的物理页组成(通常只有一页)。单个slab可以在 slab 链表之间移动,例如如果一个「半满slabs_partial链表」被分配了对象后变满了,就要从 slabs_partial 中删除,同时插入到「全满slabs_full链表」中去。内核slab对象的分配过程是这样的:

- 如果

slabs_partial链表还有未分配的空间,分配对象,若分配之后变满,移动slab到slabs_full链表 - 如果

slabs_partial链表没有未分配的空间,进入下一步 - 如果

slabs_empty链表还有未分配的空间,分配对象,同时移动slab进入slabs_partial链表 - 如果

slabs_empty为空,请求伙伴系统分页,创建一个新的空闲slab, 按步骤 3 分配对象

命令查看:

我们可以通过cat /proc/slabinfo 命令,实际查看系统中slab 信息。

salbtop实时显示内核slab内存缓存信息。

slab高速缓存的分类:

slab高速缓存分为两大类,「通用高速缓存」和「专用高速缓存」。

通用高速缓存:

slab分配器中用 kmem_cache 来描述高速缓存的结构,它本身也需要 slab 分配器对其进行高速缓存。cache_cache 保存着对「高速缓存描述符的高速缓存」,是一种通用高速缓存,保存在cache_chain 链表中的第一个元素。

另外,slab 分配器所提供的小块连续内存的分配,也是通用高速缓存实现的。通用高速缓存所提供的对象具有几何分布的大小,范围为32到131072字节。内核中提供了 kmalloc() 和 kfree() 两个接口分别进行内存的申请和释放。

专用高速缓存:

内核为专用高速缓存的申请和释放提供了一套完整的接口,根据所传入的参数为指定的对象分配slab缓存

8.虚拟内存的分配:

前面是对于物理内存的管理,Linux通过虚拟内存管理,欺骗了用户程序假装每个程序都有 4G 的虚拟内存寻址空间

所以我们来研究下虚拟内存的分配,这里包括用户空间虚拟内存和内核空间虚拟内存。

用户空间内存分配:

mallco:

malloc用于申请用户空间的虚拟内存,当申请小于128KB内存的时候,malloc使用sbrk或brk分配内存;当申请大于128KB内存的时候,使用mmap函数申请内存

存在的问题:

由于 brk/sbrk/mmap 属于系统调用,如果每次申请内存都要产生系统调用开销,cpu 在用户态和内核态之间频繁切换,非常影响性能。

而且,堆是从低地址往高地址增长的,如果过低地址的内存没有被释放,高地址的内存就不能被回收,容易产生内存碎片。

解决:

因此,malloc采用的是内存池的实现方式,先申请一大块内存,然后将内存分成不同大小的内存块,然后用户申请内存的时候,直接从内存里面选择一块相近的内存块分配出去。

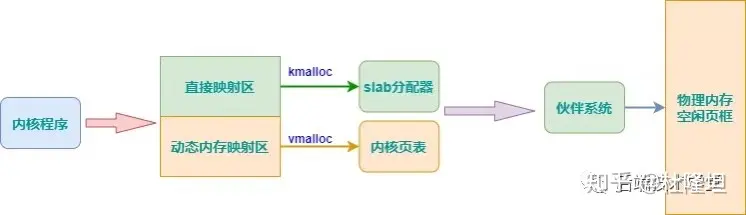

内核空间内存分配:

在讲内核空间内存分配之前,先来回顾一下内核地址空间。kmalloc 和 vmalloc 分别用于分配不同映射区的虚拟内存,看这张上次画的图:

kmalloc:

kmalloc() 分配的虚拟地址范围在内核空间的「直接内存映射区」

按字节为单位虚拟内存,一般用于分配小块内存,释放内存对应于 kfree ,可以分配连续的物理内存。函数原型在 <linux/kmalloc.h> 中声明,一般情况下在驱动程序中都是调用 kmalloc() 来给数据结构分配内存 。

kmalloc 是基于slab 分配器的 ,同样可以用cat /proc/slabinfo 命令,查看 kmalloc 相关 slab 对象信息,kmalloc-8、kmalloc-16 等等就是基于slab分配的 kmalloc 高速缓存。

vmalloc:

vmalloc 分配的虚拟地址区间,位于 vmalloc_start 与vmalloc_end 之间的「动态内存映射区」。

一般用分配大块内存,释放内存对应于 vfree,分配的虚拟内存地址连续,物理地址上不一定连续。函数原型在 <linux/vmalloc.h> 中声明。一般用在为活动的交换区分配数据结构,为某些 I/O 驱动程序分配缓冲区,或为内核模块分配空间。

Comments | NOTHING